はじめに

データ分析業に転職してから、機械学習や統計学の手法を中心に学んで来たのですが、それってデータありきの話なんですよね。

データ分析をビジネスに活用するためには、まずデータそのものの準備や適切な管理が必要になります。

Garbage in Garbage outという言葉もありますもんね。

在宅勤務で時間に余裕ができた今、データマネジメントについて学んでみることにしました。

勉強材料

データマネジメントを学ぶ書籍としては、

「データマネジメント知識体系ガイド(DMBOK)」というバイブルがありますが、600P超えで如何せん初心者にはハードルが高いです💦。

と思っていたところ、この本を実務者の経験を踏まえて要約した書籍がありました。

その名も「データマネジメントが30分でわかる本」。この本の優れている点はタイトルに書かれているとおり30分でデータマネジメントの概要が分かる点です。

章ごと所要時間別に要約が記載されています。これは非常に便利で、全体をザックリ把握してから詳細を読み進めることができます。私はまず、各章の30秒コースを全て読み、その後3分コース→30分コース→3時間コースと読み進めました。初学者の方はDMBOKを読む前に一読することをおすすめします。

●【30秒コース】一言で!

●【3分コース】なにそれ

●【30分コース】どうして

●【3時間コース】ケーススタディ

データマネジメントが30分でわかる本書籍の購入はこちらから↓

Amazon CAPTCHA

製造現場におけるデータマネジメントを考えてみる

私は元半導体の生産技術者なので、良くも悪くも事例を製造現場に置き変えて考えてしまいます。

上記書籍はWeb系の事業会社を題材にしたものですが、過去の経験を踏まえて、メーカーの製造現場でのデータマネジメントについて考えたいと思います。

ネタバレしない範囲で、各章ごとに学んだことを述べたいと思います。

第1章 データアーキテクチャ

データ分析の目的はあくまで、ビジネスで価値を出すことです。データとビジネスを紐つける青写真(データアーキテクチャ)が必要になります。

例えば、製造現場に於いては、以下のことがイメージされます。

いずれも「生産性向上」のための施策になります。

● 工程ごとの進捗率が自動的に可視化される

● 工程ごとの不良率が自動的に可視化、保存される

● 装置のログが自動的に可視化、保存される

(不良率とログは同じダッシュボードで見られるようにする。相関があるかもしれないので)

過去を振り返ると、データを現場で探すのに時間を要していたので、まずその時間を無くすことを目指したいと思います。

可視化は従来Excelのグラフで行っていましたが、BIツールを使って色々な角度からデータを確認できるようにしたいです。

製造工程のデータアーキテクチャ

第2章 データストレージとオペレーション

データから価値を生みたいのであれば、データの管理を属人化させるのではなく、管理するシステムをしっかり作りましょうね!

ということと理解しました。私がかつていた現場と目指す姿との比較は以下になります。

| 現状 | 目指す姿 | |

|---|---|---|

| データの保管場所 | 現場のPCと 工程担当者のデスクPC |

データベース |

| データの運搬 | USB | データアーキテクチャ |

第3章 データ統合と相互運用性

ゴールに到達するためには、抽出(Extract)、変換(Transform)、取り込み(Load)(ETLと呼ばれる)を業務の要件を満たすように行う必要があります。そのためには、まず要件を定義しないといけません。

例えば、不良率の可視化の例だと、不良が多発した場合緊急的にラインを停止する必要があります。そのため、不良率は製品ごとにデータの更新、可視化を行う必要があります。1日の生産が終わった後に実はめちゃくちゃ不良率高かったことが分かっても後の祭りです。

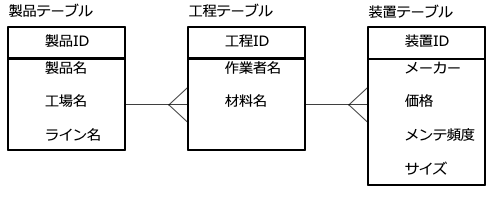

第4章 データモデリングとデザイン

事業が大規模になってくると、データ量が増え、データどうしの関連が複雑になってきます。データの関連性がこんがらがるとデータ活用に於いてリスクでしかありません(不要なデータを混入させたり、必要なデータを消したり)。データどうしの関連を整理する必要があります。DMBOKではデータの粒度を次の3段階に分けて整理しています。

● 概念モデル

基本的で重要な概念のみが表現されたもの(Ex. そのラインで作られる製品群)

● 論理モデル

詳細な用件が記載されたもの。ただし、実装上の課題は考慮しない

(例)

・その製品の工程一覧

・工程ごとの担当者一覧

・工程ごとの製造装置一覧

● 物理モデル

具体的な技術的ソリューションを指し、

論理モデルをデータベース上のテーブルとして表現した関連図(ER図)

例えばある製品データについてのER図を作ってみました。

製品データのER図(イメージ)

この章で重要と感じた言葉に「モデルストーミング」という言葉があります。

これは、皆で紙やホワイトボードにデータモデリングの案を書き出してブラッシュアップする作業です。

色々な人の意見を聞いてコミュニケーションを上手く取りながら進めて行くのが重要そうです(どんな仕事でもそうですが)。

また、大企業になると工場毎が別会社みたいなものなので、モデルストーミングするメンバーを以下のように分けたほうが良さそうです。別々の工場で同じような工程がある場合、データを共有できれば不良原因に早く辿り着けるかもしれません(他の工場で過去に同じような問題に直面し、既に解決済である可能性がある)。

ある製品のデータモデル

第5章 マスターデータ管理

データは一貫した信頼できる状態(マスターデータ)で管理することを学びました。

Excelファイルなどでよくあるのですが、複数似たような名前のファイルがあり、どのファイルが最新か分からず利用者が 混乱する場面です(笑)

マスターデータで管理することで無駄なコストを無くすことができます。書籍にはマスターデータの管理を行うのに便利なツールについて記載さています。

第6章 ドキュメントとコンテンツ管理

さてここまでは、構造化データに注目してきましたが、データには非構造化データもあります。非構造化データは管理の目が届きにくく、忘れさられがちなので注意が必要です。非構造化データには以下のようなものがあります。

● 製品の設計図

● 製品の組みたて図

● 作業要領書

● 作業手順書

非構造化データはWordに書かれたドキュメントをイメージしました。

このようなデータにはメーカーのノウハウが濃縮されているため、構造化データよりも重要かもしれません。過去にサイバー攻撃で狙われたのもこの手のデータが多いように思います😱。

第7章 データセキュリティ

ある意味この章が一番重要かもしれません。情報流出は顧客の信頼を失いますし、市場競争力も落ちます。

この章には私が前から気になっていたことが書かれていました。「クラウドでのデータ保護はオンプレと同じレベルで可能か?」についてです。

作者の見解は書籍で確認いただきたいですが、私はエッジAIのクラウドAIに対する利点はセキリュティが強固なことと思っていました。

しかし、そう決めるけるのは早計と思い始めました。この点については追加調査するつもりです。

第8章 データ品質

データ品質は利用者のニーズを満たしているか否か(=ビジネスに活用できるか否か)で決まることを理解しました。

例えば、検査データを例に挙げると、製品規格がμ±3σだとして、検査装置の測定ばらつきの標準偏差が3σだと話になりません。

また、測定精度が要求を満たしていても欠損が多ければ問題になり得ます。極端な例ですが、この場合データ品質が低いということになりますね。

データ品質が低い場合に起こること

書籍にはデータ品質が低い場合の様々なリスクが載っています。

また、なるほどと思ったのですが、はじめに各データの品質を定義してやる必要があります。ゴールを明確にしておき、過剰品質を避けます。

前述の検査データの例だと、測定ばらつきを0にすることはできません。なので、測定ばらつきのせいで、規格外れを規格内、規格内を規格外れと判定する確率を0にはできません。しかし、ほとんど起こり得ないことを想定してデータ品質を追求することはコストの観点から得策でないです。

どこまで追求するのか初めに線引きをしておかなければいけません。

第9章 データウェアハウジングとビジネスインテリジェンス

意思決定を支えるデータを、適切なタイミングで意思決定者に提示するシステムを構築することと理解しました。

単にシステムを構築するのではなく、現場のビジネスロジックに沿った可視化やレポーティングが行われなければいけません。

筆者は利用者のニーズを正しく捉えるために5W1Hの観点でデータの活用を整理しており、非常に参考になりました。

私が担当していた業務に置き換えてみると以下のようになります。

歩留り改善のためのBI構築に向けての5W1Hデータフローの設計も重要になります。従来は生産技術者が装置や現場のPCからデータを抜き取って指標を集計、Excelで可視化していましたが、以下のようなデータフローを構築すればその作業を無くすことができ、創造的な業務に時間を割くことができます。システムを構築する際の費用対効果を的確に見積もれ、周囲を牽引できる人が社内で重宝されると思います。

歩留り改善に向けてのデータフロー

第10章 メタデータ管理

メタデータ管理とは「データを説明するデータを管理」することを指します。製造工程から出てくるデータを読み解くには専門知識が要るので生データは工程担当者しか見ません。また、万人が理解できる必要もないと考えています。なので、工程担当者がデータの意味を理解していれば良いとも考えられるのですが、、

市場不具合などが発生すると製造データを顧客に開示する必要が発生し、メタデータの管理が杜撰だと追及される可能性があります(だから、整備しておくわけではないですが)。ISO 9001の観点からも重要と言えそうです。

第11章 データガバナンス

これまでの章の内容を実践するために、社内のルールを定めて組織的な意思決定を行うことです。

ROIを最大化するために、以下が重要となります。

● 課題の特定

闇雲にデータ基盤を構築してもビジネスに活用できる訳ではありません。初めに現場や意思決定者と共に課題を明文化して「あるべき姿」を決めましょう。

● 案件の分割

半導体製造には多数の工程があるため、データ基盤の構築も複雑になると思われます。工場内の各ラインについて、上記のデータフローを構築していきますが、初めから完璧なものを目指すと挫折します(笑)。初めは、取り組み易い現場、製品、工程から着手しましょう。

● 段階的にリリースする

前述の内容と被るのですが、手戻りを無くすにはスモールスタートが重要ということです。基盤構築の各段階に細かくホールドポイントを設けて関係者に使い勝手などの意見を聞きながら進めましょう。

● 定性情報の活用

これはWeb業界の事例と、私が志向している製造現場の事例で話が違ってくると思いますが、データに疑問があれば、数字だけから読み解こうとするのではなく、製造員や装置メーカーにヒアリングしようということ捉えました。その事象が起こっているのが現場なので、実地でのヒアリングから有益な情報が得られることが多いです。

最後に

書籍を読了して、

データ活用でビジネス価値を創出したいなら、データマネジメントから!

ということが理解できました。

車を使って移動時間を節約したかったら、良いエンジンも大切ですが、整備された道と精製された燃料が必要ですよね?車がポンコツでもこの二つをしっかり作れば生産性が上がる事例もあると思います(例えが下手ですみません)。生産技術の場合、データからインサイトを得るのはまだ機械化できない要素が多いです。なので、データの収集、抽出、変換を自動化し、その時間を節約することで、インサイトを得るまでの時間を短縮する(ひいては意思決定までの時間を短縮する)ことに価値があると感じます。

言うは易く行うは難しで、結局データマネジメントには以下の能力が求められのではないかと思いました。やはりこの壁を超えないとですね。。

「あなたもたったの3ヶ月でデータサイエンティストに!!……なれるなんて本気で思ってるの? ~データラーニングスクール設立に込めた3つの想い~」 から引用

・ビジネス上の課題を見つけて、良き問いをしっかりと立てられること

・その問いの対して適切な解決策を提案できる幅広い知識と経験、バランス感覚

・自分の持てる武器を使ってしっかりと問題の解を導き出すこと

・そこから導き出された答を現場に浸透させてビジネス価値に転換すること